2‣ Enclencher une boucle de rétroaction

Comment l'évaluation peut-elle devenir un véritable moteur d'apprentissage plutôt qu'un simple constat de performance ? Des critères et des barèmes précis, un simple tableur et un petit coup de pouce de l'IA peuvent permettent un retour d'information crucial pour l'apprenant·e.

Le processus est très linéaire, et ressemble à une course : l'élève fait une production et démontre son degré de maitrise de la compétence ; l'enseignant·e évalue le résultat et communique une note. Comment l'évaluation peut-elle devenir un véritable «moteur» d'apprentissage plutôt qu'un simple constat de performance ? S'il suffisait de mettre dans le processus un peu plus d'information et de faire un retour, pourrait-on changer la donne ? En appliquant des critères et des barèmes constants pour tous les travaux – tant formatifs que sommatifs – et en intégrant des retours informatifs réguliers, on peut développer une boucle de rétroaction qui, par sa nature même, participera à l'apprentissage.

Des critères et des barèmes réguliers

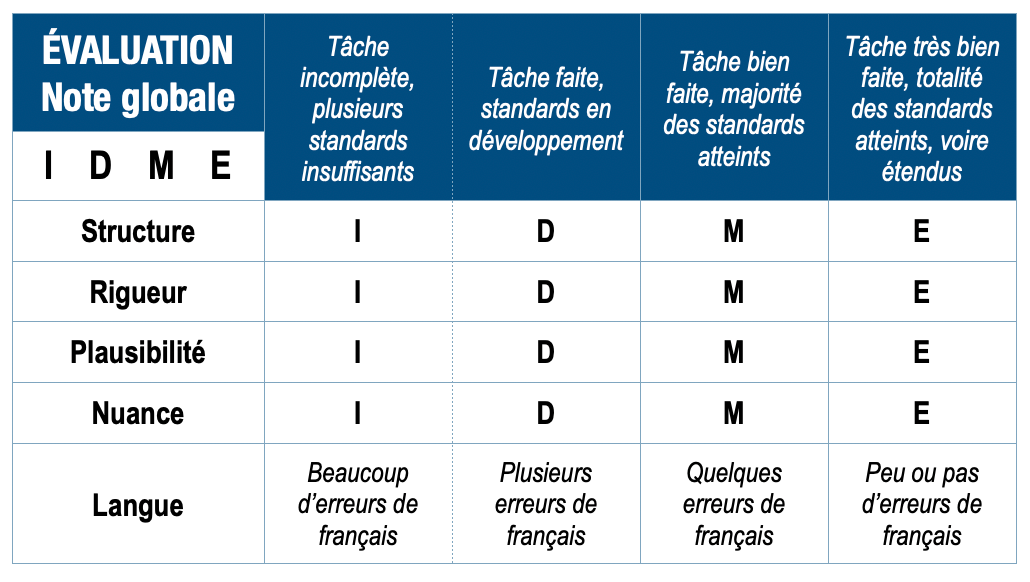

► DANS cette approche expérimentale, j’utilise des critères réguliers tout au long du trimestre, tant pour les artefacts du dossier d'apprentissage que pour l'analyse finale qui certifiera l’atteinte de la compétence. J'utilise des critères, constants et pondérés, inspirés de l'approche ELLAC pour évaluer les compétences en littératie :

- La structure : organisation logique et cohérente des idées (15%)

- La rigueur : exhaustivité et systématicité des observations (20%)

- La plausibilité : crédibilité et pertinence des preuves (10%)

- La nuance : finesse et richesse du regard analytique (25%)

- La qualité de la langue (30%)

Appliqués de façon continue durant toute la session, ces critères permettent d'évaluer assez aisément le développement des étudiants, d'identifier les forces et les défis et d'y remédier.

Chaque critère est évalué en fonction d'un barème de progression. La taxonomie SOLO est un outil de premier plan pour évaluer la progression des apprentissages. Elle présente quatre niveaux de maîtrise que j'ai adaptés à mon contexte.

- Incomplet/insuffisant (I) : compréhension parcellaire, sous le seuil requis

- En développement (D) : compréhension d'éléments multiples mais non intégrée

- Maîtrisé (M) : compréhension relationnelle établie

- Étendu (E) : capacité d'abstraction et d'application étendue

Créer une rétroaction informative

Comment peut-on produire pour l'élève une information riche et efficace, qui dresse un portrait juste de l'apprentissage, sans tomber dans les généralités ou sans crouler sous la différenciation ? Il s'agit de construire une banque commentaires pré-rédigés qui combinent les critères d'évaluation et les barèmes. Voici quelques astuces :

- Lors de l'évaluation, l'enseignant identifie les barèmes (ou les niveaux de maitrise) qui correspondent le mieux au travail examiné. Il est crucial de vérifier que les descriptions informatives adressées à l'élève soient concrètes et pertinentes, en évitant les généralités ambiguës. Pour accentuer l'effet informatif de cette communication et favoriser la motivation de maitrise, l'apprenant·e reçoit uniquement les codes (I, D, M, E) sans note chiffrée.

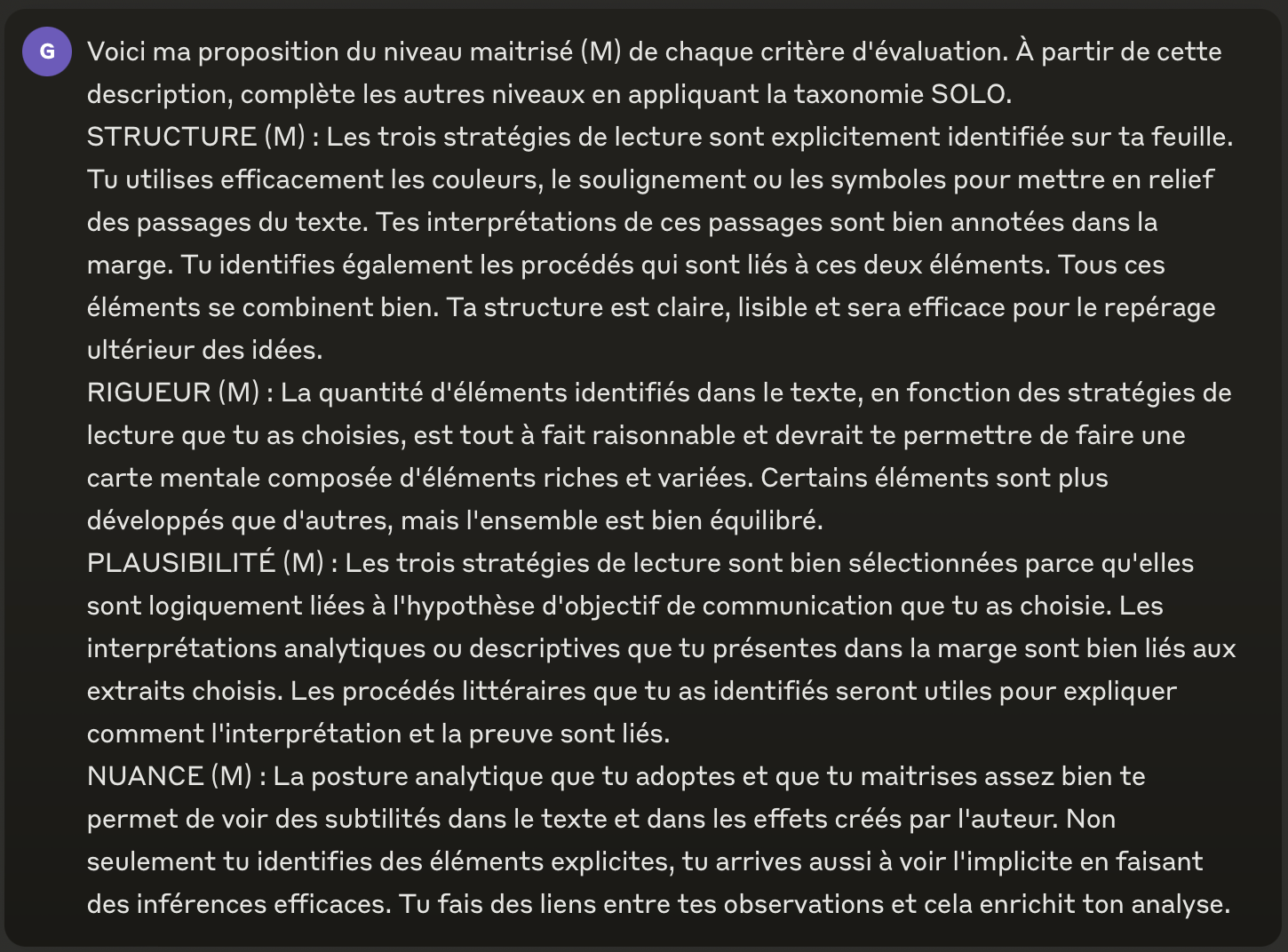

- Il faut d'abord décrire les niveaux de maitrise, c'est-à-dire le barème (M) pour chaque critère. Qu'est-ce qu'une structure maîtrisée ? Qu'est qu'une rigueur maitrisée ? Comment ça se voit dans un texte ? Ces descriptions servent de points de référence pour l'ensemble de l'évaluation. Pour chacun des critères et des barèmes «M», on peut rédiger un texte de 45 à 65 mots qui détaille précisément les éléments observables attendus. Les commentaires des barèmes I, D et E sont ensuite plus faciles à créer.

- Pour accélérer le processus, l'intelligence artificielle (ici Claude 3.5 Sonnet) peut être utilisée pour générer les descriptions ces autres niveaux (I, D, E). Les descriptions générées doivent ensuite être validées et ajustées manuellement par l'enseignant·e. Mais la création d'une banque complète prend environ 45 minutes.

- Ensuite, la création de la rétroaction spécifique à l'élève – à partir de l'évaluation – s'effectue via un tableur (Excel, Numbers, Google Sheets). Les barèmes pour chaque critère sont convertis en valeurs numériques (1, 2, 3, 4) pour faciliter le traitement des données. Une formule, développée avec l'aide de l'IA, permet de pondérer chaque critère et d'établir la note globale du travail.

- L'évaluation d'un exercice simple nécessite entre trois et cinq minutes, tandis qu'une évaluation plus complexe peut prendre jusqu'à dix ou douze minutes. Évidemment, les premières utilisations de ce système demandent plus de temps, mais la pratique permet d'accélérer le processus.

- Enfin, les résultats sont transférés dans le système de gestion Omnivox/Lea pour communication aux étudiants.

Une boucle d'apprentissage

En travaillant toujours avec les mêmes critères, l’enseignant·e est en mesure de les ajuster régulièrement et de les rendre plus «universels» et applicables à tous les travaux. De leur côté, les élèves les comprennent de mieux en mieux et se les approprient tout autant. La méthode est efficace pour identifier de manière longitudinale les critères qui se révèlent les mieux maitrisés ou non.

Par exemple, au niveau D, un étudiant n'est pas en situation d'échec mais plutôt en phase active de développement de ses compétences. Cette zone large de développement valorise les efforts et les progrès, même si la maîtrise n'est pas encore atteinte. Le niveau Maîtrisé (M) crée une zone intermédiaire qui encourage la progression vers la maîtrise tout en reconnaissant que le développement des compétences est toujours en cours. Cette structure incite les étudiants à persévérer au-delà du simple «passage» du cours, puisque la zone de développement s'étend significativement au-dessus du seuil traditionnel de réussite de 60%.

Certes, le traitement dans le tableur implique forcément des notes chiffrées, mais celles-ci ne sont pas utiles à l’élève pour le développement de son apprentissage. Ce qui est vraiment important, c'est l'information qui lui est retournée. La notation par «codes» permet de produire une rétroaction différenciée.

Si la note chiffrée est généralement pauvre en information, la pratique décrite ici ici au contraire de retourner à l’élève une rétroaction utile, spécifique et orientée vers l'amélioration. L'enseignant·e est en mesure de générer un commentaire descriptif détaillé de 200 à 350 mots qui correspond assez bien au travail de chaque élève. On pourrait bien sûr créer une rétroaction à partir d’une plage de notes chiffrées, mais l’intérêt de la notation non chiffrée est d’éviter la comparaison à une moyenne de groupe, amenuisant ainsi la compétition entre élèves et le stress associé.

Bien que la mise en place initiale du système de rétroaction demande du temps, Si on considère l’effet qu’elle peut avoir, disons que cette rétroaction automatisée est un investissement plutôt payant !

Comme l’écrivent Biggs et Collis (1982), «il existe un besoin urgent de critères qualitatifs d'apprentissage ayant une valeur tant formative que sommative. La mise en correspondance des résultats d'apprentissage avec les intentions initiales d'apprentissage devrait se faire en des termes tels que l'information ainsi fournie devienne une rétroaction précieuse tant pour l'enseignant que pour l'élève.» (p. 15).

Car, en effet, l’enseignant·e, tout comme l’élève, peut tout aussi bien constater un problème récurrent de structure, de nuance ou de plausibilité – la récurrence a ceci de bon qu’elle permet de confirmer les forces et les faiblesses et elle permet de fixer des objectifs concrets et ciblés. De plus, on le verra plus tard, en analysant le tableur (la matrice principale de suivi des résultats), l’IA est en mesure de voir des patterns dans l’apprentissage, parfois les blocages qui surgissent et qui indiquent l’urgence d’une intervention. On en parlera dans une autre chronique.

À partir de ces pistes, il est donc possible de sortir du processus linéaire et de créer un environnement d'apprentissage qui est dynamique et engageant. Comme nous le verrons plus tard, il est possible d’agir dans cet espace systémique. Les étudiants reçoivent un feedback fréquent et précis, leur permettant de voir clairement leur progression et les aspects à améliorer, et cette boucle de rétroaction informative transforme l'enseignement et l’apprentissage en un processus très interactif, ancré dans des compétences concrètes et observables de part et d’autre. C’est très motivant, parce que l’apprentissage est visible, autant par l’enseignant que par l’élève. Si les éléments requis sont bien en place, se produisent alors les premières émergences du système : l’apprentissage nourrit la motivation, et la motivation enclenche l'engagement nécessaire à l'apprentissage. La boucle devient récursive : le système devient un moteur.

L'évaluation n'est pas la fin du processus, mais un nouveau début. Si l'étudiant n'a pas atteint les exigences ou objectifs initiaux, alors qu'est-ce qui n'a pas fonctionné ?

Biggs & Collis, Evaluating the Quality of Learning, p. 7

L'IA pourra certainement automatiser tout ce processus à l'avenir, mais la méthode actuelle, bien qu'artisanale, atteint tout à fait les objectifs d'engagement et de motivation. Lors d'une évaluation de la première phase de ce projet pilote par les élèves à l’hiver 2024 (n=44), il s'est avéré que 95% d'entre eux et elles trouvaient les rétroactions éclairantes et utiles pour leur apprentissage._ ◀︎

Modalités éditoriales

H

CC BY-SA 4.0 (Attribution - Partage dans les mêmes conditions)

Publié le 8 octobre 2024 · Révisé le 12 août 2025

Références

BIGGS, John B. & Kevin F. Collis (1982), Evaluating the Quality of Learning ; The SOLO Taxonomy (Structure of the Observed Learning Outcome). Elsevier Inc.

À explorer

Pour comprendre le cadre théorique :

- 7‣ Dépister avec la taxonomie SOLO - Les fondements de l'évaluation qualitative et des niveaux IDME qui permettent la rétroaction différenciée

Pour voir l'application concrète :

- 11‣ Enseigner la lecture littéraire au collégial - L'approche ELLAC qui fournit les critères constants (structure, rigueur, plausibilité, nuance) du système de rétroaction

Pour approfondir le paradigme :

- 5‣ Mettre en place une pratique alternative de notation (PAN) - L'abandon des notes chiffrées au profit d'une évaluation qualitative qui transforme l'erreur en opportunité

Pour une vision d'ensemble :

- 40‣ Concevoir la classe comme un écosystème d'intelligence - Comment les boucles de rétroaction s'articulent dans la dynamique globale de l'apprentissage